Recurrent Neural Networks (RNN) |

|

Diese Seite wurde seit mehr als 7 Monaten inhaltlich nicht mehr aktualisiert.

Unter Umständen ist sie nicht mehr aktuell.

Diese Seite wurde seit mehr als 7 Monaten inhaltlich nicht mehr aktualisiert.

Unter Umständen ist sie nicht mehr aktuell.

BiblioMap

BiblioMap

Synonyme

Synonyme

Recurrent Neural Networks, RNN

Definitionen

Definitionen

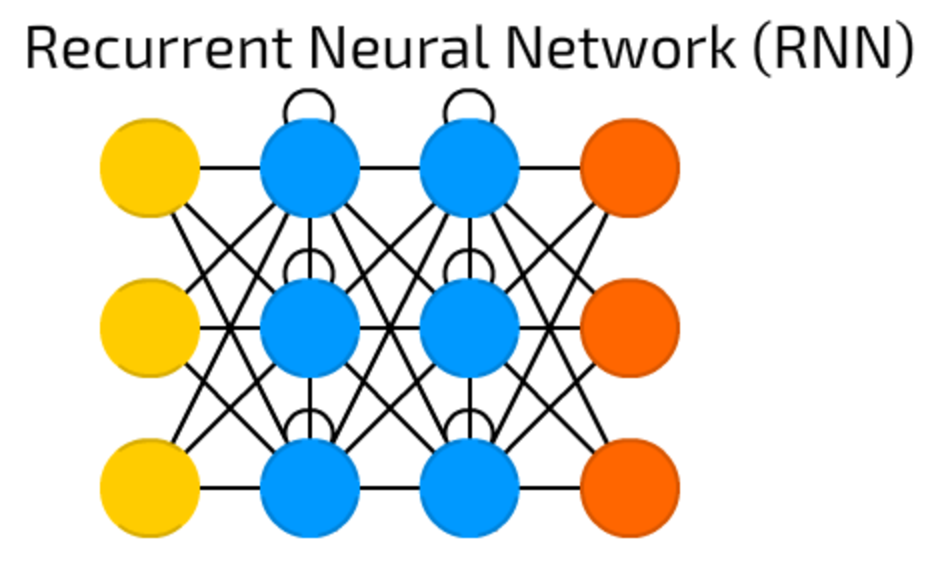

Recurrent Neural Networks introduce different type of cells — Recurrent cells. The first network of this type was so called Jordan network, when each of hidden cell received it’s own output with fixed delay — one or more iterations. Apart from that, it was like common FNN.

Von Andrew Tch im Text The mostly complete chart of Neural Networks, explained (2017)  Eine weitere bedeutsame Erweiterung sind RNN. Während CNN

besonders gut mit Daten umgehen können, die in (zwei) Dimensionen angeordnet sind, sind RNN auf

sequentielle Daten spezialisiert. Daher sind diese Modelle besonders erfolgreich bei der Textverarbeitung.

Eine der erfolgreichsten Implementationen von RNN ist das sog. long short-term memory

(LSTM), welches am Istituto Dalle Molle di Studi sull'Intelligenza Artificiale (IDSIA) in Lugano

entwickelt wurde. Die darauf basierenden Algorithmen werden heute in rund 3 Milliarden Smartphones

täglich benutzt und betreiben u.a. die Spracherkennung und Übersetzung von Google sowie die Übersetzung

bei Facebook.

Eine weitere bedeutsame Erweiterung sind RNN. Während CNN

besonders gut mit Daten umgehen können, die in (zwei) Dimensionen angeordnet sind, sind RNN auf

sequentielle Daten spezialisiert. Daher sind diese Modelle besonders erfolgreich bei der Textverarbeitung.

Eine der erfolgreichsten Implementationen von RNN ist das sog. long short-term memory

(LSTM), welches am Istituto Dalle Molle di Studi sull'Intelligenza Artificiale (IDSIA) in Lugano

entwickelt wurde. Die darauf basierenden Algorithmen werden heute in rund 3 Milliarden Smartphones

täglich benutzt und betreiben u.a. die Spracherkennung und Übersetzung von Google sowie die Übersetzung

bei Facebook. Bemerkungen

Bemerkungen

This type of NNs is mainly used then context is important — when decisions from past iterations or samples can influence current ones. The most common examples of such contexts are texts — a word can be analysed only in context of previous words or sentences.

Von Andrew Tch im Text The mostly complete chart of Neural Networks, explained (2017)  Verwandte Objeke

Verwandte Objeke

Verwandte Begriffe (co-word occurance) |  Long / Short Term Memory (LSTM)(0.25) Long / Short Term Memory (LSTM)(0.25) |

Häufig co-zitierte Personen

Häufig co-zitierte Personen

Statistisches Begriffsnetz

Statistisches Begriffsnetz

Zitationsgraph

Zitationsgraph

Zitationsgraph (Beta-Test mit vis.js)

Zitationsgraph (Beta-Test mit vis.js)

6 Erwähnungen

6 Erwähnungen

- The mostly complete chart of Neural Networks, explained (Andrew Tch) (2017)

- Deep Learning (John D. Kelleher) (2019)

- Herausforderungen der künstlichen Intelligenz - Bericht der interdepartementalen Arbeitsgruppe «Künstliche Intelligenz» an den Bundesrat (Interdepartementale Arbeitsgruppe künstliche Intelligenz) (2019)

- Data, Knowledge, and Computation (Christian Igel) (2021)

- Attention Is All You Need (Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N. Gomez, Lukasz Kaiser, Illia Polosukhin) (2023)

- Das müssen Sie über KI wissen - c't 11/2024 (2024)

- Die Säulen der Moderne (Jan Mahn)

- Die Säulen der Moderne (Jan Mahn)

Geoffrey

Geoffrey

Biblionetz-History

Biblionetz-History