The program that swallowed the internetMike Sharples, Rafael Pérez y Pérez

Zu finden in: Story Machines, 2022

|

|

Zusammenfassungen

Zusammenfassungen

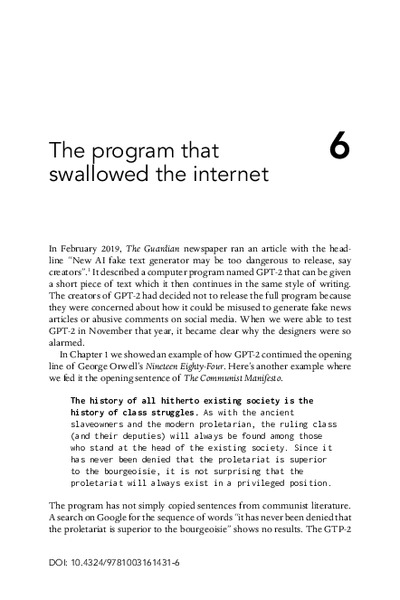

In 2019, the OpenAI company released a computer program, GPT-2, that, given a short piece of text, can continue to compose in the same style. GPT-2 is one example of a generative neural network. The system is trained on millions of texts from the internet, and then it is tested by being given a sequence of words it hasn’t previously seen, and it is judged on how well it predicts the next word. Then, a user presents it with an opening sequence of words, and it adds a word to the sequence, takes the new sequence as input, and continues to generate text, word by word. Such systems are hugely proficient producers of language but have fundamental limitations: they do not understand what they write, and they have no common-sense understanding of how people and objects behave.

In 2019, the OpenAI company released a computer program, GPT-2, that, given a short piece of text, can continue to compose in the same style. GPT-2 is one example of a generative neural network. The system is trained on millions of texts from the internet, and then it is tested by being given a sequence of words it hasn’t previously seen, and it is judged on how well it predicts the next word. Then, a user presents it with an opening sequence of words, and it adds a word to the sequence, takes the new sequence as input, and continues to generate text, word by word. Such systems are hugely proficient producers of language but have fundamental limitations: they do not understand what they write, and they have no common-sense understanding of how people and objects behave. Dieses Kapitel erwähnt ...

Dieses Kapitel erwähnt ...

Personen KB IB clear | Sandhini Agarwal , Dario Amodei , Amanda Askell , Christopher Berner , Tom B. Brown , Mark Chen , Benjamin Chess , Rewon Child , Jack Clark , Kewal Dhariwal , Prafulla Dhariwal , Aidan N. Gomez , Scott Gray , Tom Henighan , Ariel Herbert-Voss , Christopher Hesse , Llion Jones , Lukasz Kaiser , Jared Kaplan , Gretchen Krueger , Mateusz Litwin , Benjamin Mann , Sam McCandlish , Arvind Neelakantan , Niki Parmar , Illia Polosukhin , Alec Radford , Aditya Ramesh , Nick Ryder , Girish Sastry , Noam Shazeer , Pranav Shyam , Eric Sigler , Melanie Subbiah , Ilya Sutskever , Jakob Uszkoreit , Ashish Vaswani , Clemens Winter , Jeffrey Wu , Daniel M. Ziegler | ||||||||||||||||||

Begriffe KB IB clear |  bias

, bias

,  Computer Computer computer

, computer

,  Daten Daten data

, data

,  Gehirn Gehirn brain

, brain

,  Generative Machine-Learning-Systeme (GMLS) Generative Machine-Learning-Systeme (GMLS) computer-generated text

, computer-generated text

,  Generative Pretrained Transformer 3 (GPT-3)

, Generative Pretrained Transformer 3 (GPT-3)

,  Geschäftsmodell Geschäftsmodell business model

, business model

,  GPT-2

, GPT-2

,  Internet Internet internet

, internet

,  Microsoft

, Microsoft

,  Neuron Neuron neuron

, neuron

,  Religion Religion religion

, religion

,  Software Software software

, uncanny valley

, software

, uncanny valley

,  Wikipedia Wikipedia

| ||||||||||||||||||

Bücher |

| ||||||||||||||||||

Texte |

|

Dieses Kapitel erwähnt vermutlich nicht ...

Dieses Kapitel erwähnt vermutlich nicht ...

Nicht erwähnte Begriffe | Chat-GPT, Digitalisierung, Generative Pretrained Transformer 4 (GPT-4), GMLS & Bildung, Google |

Tagcloud

Tagcloud

Zitationsgraph

Zitationsgraph

Zitationsgraph (Beta-Test mit vis.js)

Zitationsgraph (Beta-Test mit vis.js)

Volltext dieses Dokuments

Volltext dieses Dokuments

Anderswo suchen

Anderswo suchen

Beat und dieses Kapitel

Beat und dieses Kapitel

Beat hat Dieses Kapitel während seiner Zeit am Institut für Medien und Schule (IMS) ins Biblionetz aufgenommen. Beat besitzt kein physisches, aber ein digitales Exemplar. (das er aber aus Urheberrechtsgründen nicht einfach weitergeben darf). Es gibt bisher nur wenige Objekte im Biblionetz, die dieses Werk zitieren.

, 217 kByte)

, 217 kByte)  Biblionetz-History

Biblionetz-History